-- Olvasási idő kb.: 6 perc és 22 másodperc

Annak, aki ma kutatással foglalkozik, szakterülete mellett óhatatlanul foglalkoznia kell az olyan, a tudományos teljesítmény mérésére hivatott metrikai eszközökkel, mint a kívülállóknak meglehetősen kriptikusan hangzó Q1, Q2, Q3, Q4, a H-index vagy az impaktfaktor. Pedig nincs itt semmi varázslat: a Q1-Q4 kategóriák a tudományos folyóiratok quartilis (negyedek) szerinti besorolásai, amelyeket az adott szakterületen mért impaktfaktor alapján rangsorolnak. A Q1 a szakterület legfelső 25 százalékába tartozó folyóiratokat jelöli, az impaktfaktor pedig az idézettséget. A H-index a tanulmányokat publikáló szerzők minőségi fokjelzője, legalábbis elvben: H mennyiségű tanulmány, amelyet H alkalommal idéztek. Ha tíz tanulmányomat legalább tízszer idézték, akkor a H-indexem 10-es. Minél magasabb az idézettsége egy folyóiratnak, annál magasabb impaktfaktorral rendelkezik, bár az is igaz, hogy a folyóiratok gyakran negyedévente veszítik el Q1-es státuszukat, tehát kevés neves folyóirat tud huzamosabb ideig, éveken át Q1-es státuszban maradni.

Ezeket a neoliberális, az amerikai piaci modellből eredő tudománymetriai eszközöket külföldön és Magyarországon is érik bírálatok, de egészen más alapon: nálunk néhány hangos kormányközeli szerző politikai célokra használja a mérési rendszer kritikáját, azzal a szándékkal, hogy radikálisan átalakítsa a magyar tudományos életet. A Lentner Csaba közgazdász és Schmidt Mária történész által jegyzett, a Magyar Tudományos Akadémia (MTA) tagjait és általában a bölcsészettudományokat támadó cikkek egyik visszatérő érve, hogy a magyar bölcsészek és társadalomtudósok a nemzetközi mezőnyhöz képest sokkal kevésbé láthatók, sokkal kevesebb nemzetközi tanulmányt tesznek közzé, és sokkal rosszabb idézettségi mutatókkal rendelkeznek. Ezek a vádak azonban pontos módszertan és konkrét esetek elemzése nélkül csupán üres lózungok és sérelemből fakadó vádak, hisz egy-egy kutató tudománymetriai mutatóinak elemzése nagyon bonyolult feladat, és a témáról komoly módszertani viták zajlanak.

De hogyan válhat a tudománymetria politikai eszközzé? Egyáltalán, mi az a tudománymetria, miért méricskéljük egymást, és hogyan lehet egy kutatót számszerűsíteni?

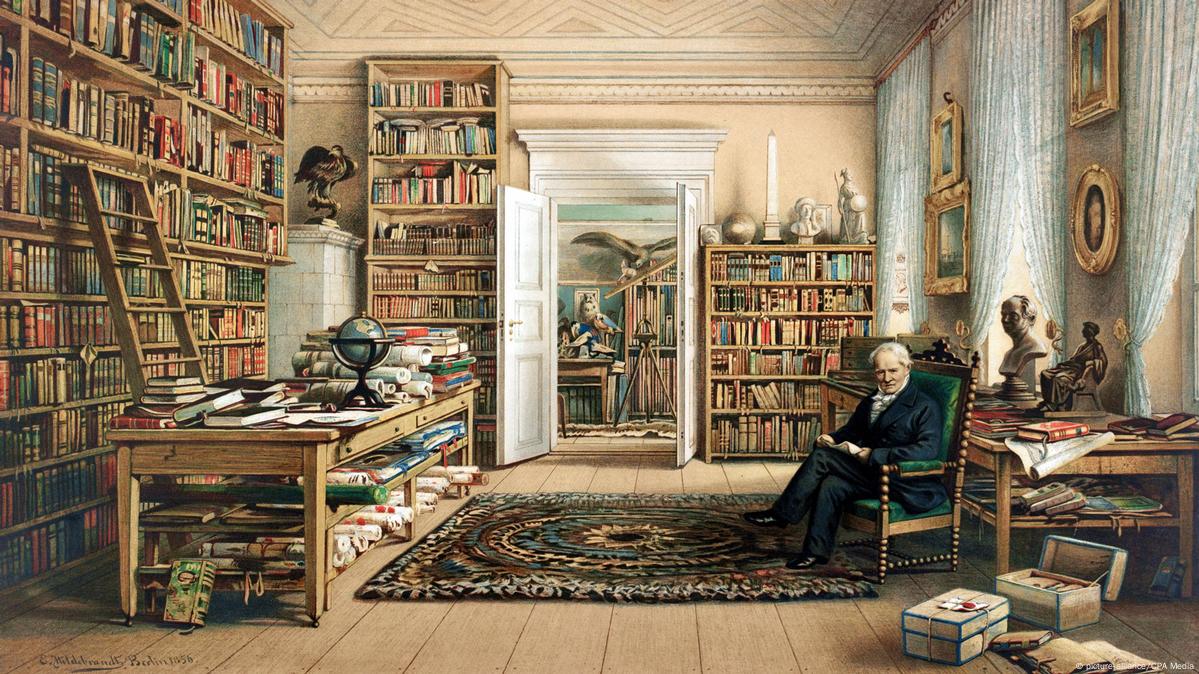

A romantikus bölcsészettudományok vége: a 19. század

Mondanom sem kell, hogy a berlini egyetemet megalapitó, a német klasszicizmus és tudományosság félisteneként tisztelt Wilhelm von Humboldtot a 19. század elején egyáltalán nem izgatta, hogy hányan idézik a munkáit. Az viszont már az ő generációjának is fontos volt, hogy szellemi és tudományos munkásságuk kontinentális hírnevet érjen el, ismerjék őket nemzetközileg (akkor ez alapvetően Európát jelentette), és tudományos teljesítményükben az emberiség eszményi, egyetemes céljai összpontosuljanak. Humboldt generációja már nem csupán egy-egy egyetem polgárságának, egy városnak vagy egy nemzetnek írt, hanem törekedett arra, hogy az iparosodás és a nagy földrajzi felfedezések új, kolonialista fejezetével lassan kibontakozó világfalut foglalja össze munkáiban.

A tudományos haladásnak ekkor alapvetően két kritériuma volt: a kiválóság (az illető a szakma legjobbja, a legnagyobb, akkor még pozitivista és polihisztori tudást igénylő ismerője legyen) és a kapcsolatok (szakmai hálózatosodás, konnektivitás, ahogy ma mondanánk). Nem ártott néha persze az sem, ha valaki arisztokrata vagy nagypolgári családból származott, bár a 19. század második feléhez közeledve egyre több szegény sorból felemelkedő tudóst és kutatót is találunk. A tudományágak fejlődésével, az új diszciplínák létrejöttével és egyetemi szintű oktatásával a tudományos publikációk mennyisége és a kutatók száma is rohamosan nőtt: míg a 19. század első felében csupán néhány ember kutatta és oktatta az ókori Egyiptom történelmét, és alig néhány ember akadt a kontinensen, aki hieroglifákat olvasott, fél évszázaddal később az egyiptológia több tucat egyetemen oktatott tudományág lett számos kutatóval, az Egyesült Államoktól Budapestig. Még nagyobb méretű robbanás következett be a természettudományok területén, ahol az orvosi, matematikai, fizikai szakirodalom olyan mennyiségben megnőtt, hogy azt egy idő után rendszerezni kellett, ezeket pedig jelentőségük, „hatásfokuk” szerint osztályozni. A tudománymetria mint a kutatás „minőségfoka” és a kutatók osztályozásának, versengésének és versenyképesítésének, ha úgy tetszik, piacositásának egyik eszköze tehát a tudománytörténet természetes velejárója: alig száz év alatt a megnövekedett számú egyetemek, a globalizálttá váló világ és a tudományos fejlődés gyors irama miatt a 19. század végére a kutatók száma néhány százról több ezerre nőtt Európában.

Az idézettségi versenyt a jogászok kezdték, bár alapvetően szakmai okokból, és nem a tudományos piacosítás, versenyképesítés céljából. A jogi esetek idézettségeinek statisztikáit vezető Shepard’s Citations volt az egyik legkorábbi olyan kiadvány, amelyben a jogi szakirodalmat idézettség alapján osztályozták, kategorizálták, elemezték. 1884 és 1900 között, kevesebb mint 16 év alatt 380 000 tudományos publikáció keletkezett globális szinten, aztán 1900 és 1910 között ez a szám megduplázódott (ebben már ott vannak Albert Einstein történelmi jelentőségű tanulmányai is). Ez vezetett oda, hogy a kutatókat – így a bölcsészettudományok művelőit is – számszerűsíteni akarták, hiszen Európában és általában nyugaton olyannyira megnőtt a kutatók száma, hogy azok „relevanciáját” és „hatásfokát” már nem csupán a humboldti elvek (kiválóság és nemzetközi kapcsolatok) szerint kellett osztályozni.

A tudománymetria születése

A 20. század első évtizedeiben a tudományos publikációk száma robbanásszerűen megnőtt, különösen a természettudományok területén, így azokat már a kutatók egy-egy tudományterületen belül sem tudták követni. A minőséget és a lassú, hosszú távú kutatásokat felváltották a hadiiparhoz, a közegészségügyhöz vagy a bankszektorhoz köthető, kompetitív, a versenyszférát idéző kutatások, ezeket pedig egy idő után nemcsak kategorizálni kellett, de relevancia szerint osztályozni is. Ennek első nyomait látjuk Alfred Lotka 1926-os munkájában, a Chemical Abstractsban, amelyet sokan az első tudománymetriai munkaként tartanak számon. 1934-ben Samuel Bradford és E. Lancaster Jones egy tanulmányban már relevancia és idézettség szerint osztályozta a fizikai témájú folyóiratokat. Az igazi váltás azonban csak a második világháború után következett be: 1955-ben Eugene Garfield létrehozta az Institute for Scientific Information (ISI) nevű intézetet, amely a kortárs szcientometria (tudománymetria) egyik alapintézménye lett.

Garfield és csapatának munkájához kötődik a folyóiratok impaktfaktorának bevezetése is, amely végérvényesen megváltoztatta a szakirodalmat, kategóriákba sorolva a ma már ezresével mérhető tudományos folyóiratokat (Q1, Q2, Q3, Q4 és megannyi más kategória). A tudománymetria mint a tudományos teljesítményt mérő, osztályozó és annak hatásfokát elemző új tudományág (valahol a tudománytörténet, szociológia, statisztika határmezsgyéjén) először az 1970-es években jelenik meg a szovjet Vaszilij Nalimov munkájának köszönhetően.

Ezek a változások kezdetben csak a természettudományokat változtatták meg, a bölcsész- és társadalomtudományok lassan zárkóztak fel. Marc Bloch és az Annales folyóirat történelemtudományokban betöltött forradalmi szerepét ma senki nem kérdőjelezné meg, a 20. század első felében az Annales szerkesztői mégsem számolták a folyóirat „hatásfokát”, impaktfaktorát és idézettségi rátáját.

A tudománymetria mostanra ipari léptékeket öltött: a folyóiratok félévente frissítik H-index számukat, impaktfaktoros állapotukat, és paranoid módon próbálják megőrizni kiemelt státuszukat, amit nagyrészt fizetős rendszerük és a neoliberális gazdaságpolitika tőzsdei kompetitivitását idéző hierarchikus rendszerük miatt hoztak létre. Már a 20. század első felében is a kutatók egynegyede produkálta az idézettség háromnegyedét, és ez mára ez az arány még inkább eltorzult: a legidézettebb tudósok még idézetebbekké válnak, és nem ritkán monopolizálnak egy-egy kutatási területet. Arra, hogy a Máté-effektus néven ismert jelenség a tudományban is megjelent, az amerikai szociológus, Robert Merton az 1960-as években hívta fel a figyelmet: „mindenkinek, akinek van, adatik, és bővelkedni fog; attól pedig, akinek nincs, még az is elvétetik, amije van”. Merton – és azóta számos jelentős tanulmány, köztük egy 100 000 kutató eredményeit vizsgáló idei Nature-kutatás – bizonyította, hogy a legidézettebb és szakmailag befutott kutatókat sokkal többen idézik, annak ellenére, hogy új, releváns és jelentős tanulmányt és kutatást évek óta nem végeznek. A tudománymetria módszerei (a kutatók H-indexének mérése, a folyóiratok impaktfaktorának és tudományos kategóriáinak megállapítása) máig nem rögzült, egyetemes szabályrendszer szerint történnek, hisz ezeknek tudományáganként radikálisan más szabályok szerint kellene működniük. Egy csillagászt, egy szerves kémiával foglalkozó kutatót, egy kutatóorvost, egy pszichológust, egy bronzkoros régészt és egy koptológust gyakorlatilag lehetetlen azonos módszerekkel mérni. Az alábbiakban néhány konkrét példán keresztül bizonyítom, hogy miért értelmetlen a tudománymetriai mutatók túlzott, a neoliberális gazdaságpolitikát idéző rendszere, és milyen megoldások jelentek meg az európai tudományos életben ennek leküzdésére.

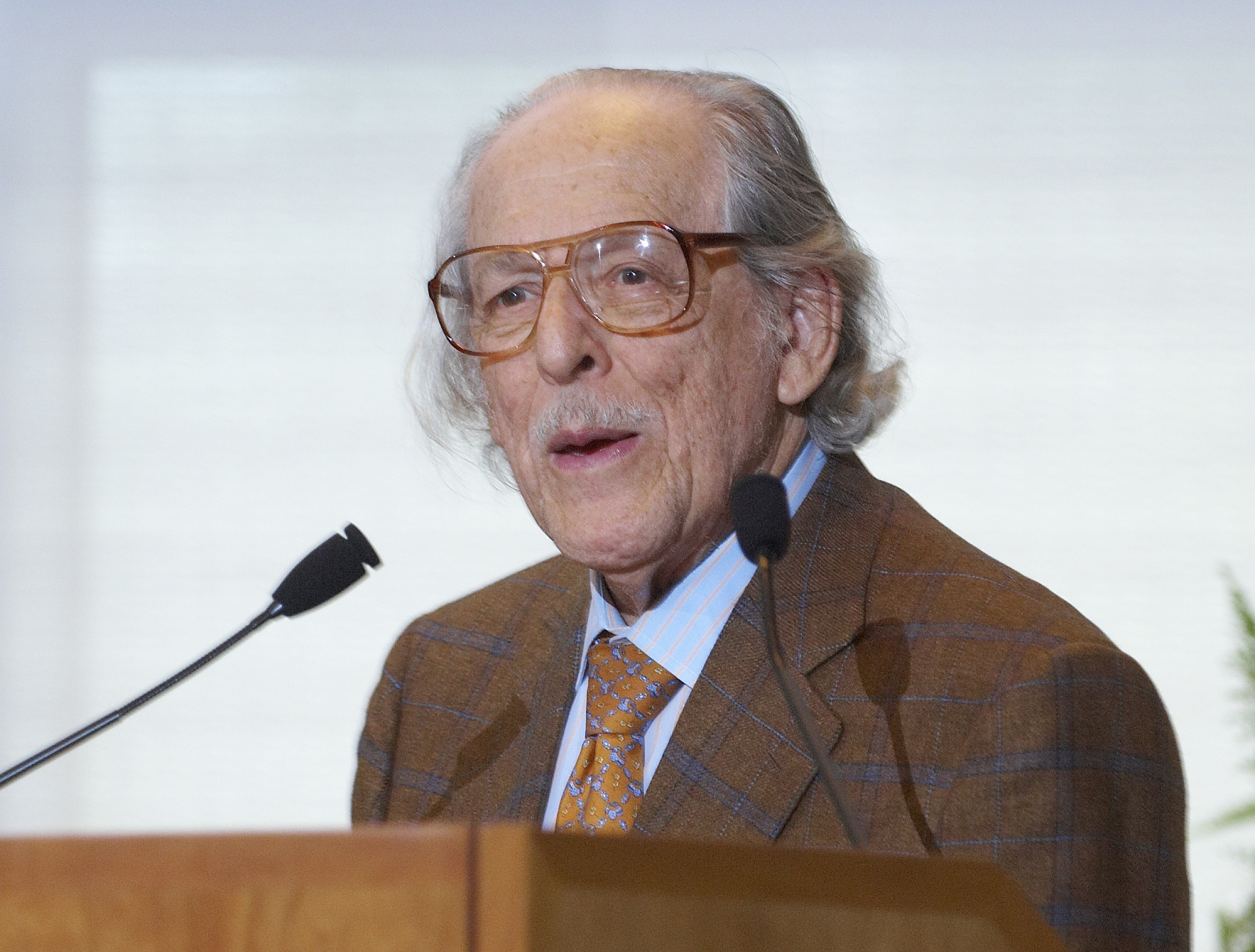

Jupiter, Mithras és a római valláskutatók mérete

Kutatóként római vallással, azon belül is a Kr. u. 1-3. század (Principatus kora) birodalmi vallási kontextusának provinciális esettanulmányaival és a dunai régió vallási életével foglalkozom. Még szűkebben, tanulmányaim nagy része eddig Dacia római provincia, Apulum (a mai Gyulafehérvár) római városának vallási forrásairól és Mithras római kultuszáról szóltak. Ez utóbbi témával ma a világon 15-20 ember foglalkozik kisebb-nagyobb intenzitással, ezek közül én a harmadik legidézettebb és a témában a legtöbb szaktanulmányt közlő kutató vagyok a szakma utolsó élő legendája, Richard L. Gordon és Aleš Chalupa után.